¿Qué es Sora de OpenAI?

OpenAI ha presentado recientemente Sora, un modelo de texto a video que transforma simples indicaciones de texto en videos de alta resolución. Sora se distingue de los modelos de video de IA anteriores por su excepcional consistencia, duración y calidad fotorrealista

¿Cuál es el alboroto en torno a Sora?

OpenAI, pionera en inteligencia artificial, es conocida por sus innovadores desarrollos en IA y modelos generativos, incluida la creación de ChatGPT. Este chatbot provocó el actual aumento del interés por la IA.

Sobre la base de esto, OpenAI ha presentado recientemente Sora, un modelo de texto a video que transforma indicaciones de texto simples en videos de alta resolución. Este modelo se basa en la experiencia desarrollada a partir de sistemas avanzados como GPT y DALL. E, lo que le permite crear escenas detalladas con múltiples personajes, movimientos variados y detalles de fondo precisos.

ChatGPT es un chatbot que ofrece interacciones que imitan de cerca la conversación humana a través de un potente modelo de lenguaje grande impulsado por IA generativa. Del mismo modo, DALL. Otro producto de OpenAI es un modelo de IA, que permite a los usuarios transformar descripciones de texto en imágenes claras.

Sora se distingue de los modelos de video de IA anteriores por su excepcional consistencia, duración y calidad fotorrealista. Los esfuerzos anteriores en videos generados por IA generalmente carecían de calidad y realismo, pero Sora representa una mejora notable. Actualmente, Sora es capaz de generar videos que duran hasta un minuto. Este proceso implica algo más que la creación de una secuencia de imágenes para simular el movimiento; también realiza un seguimiento de la posición de los objetos, asegurándose de que se muevan de forma realista e interactúen correctamente con otros elementos, como moverse uno delante o detrás del otro.

Esencialmente, Sora es a la generación de videos lo que ChatGPT es a la interacción de texto y lo que DALL. E es a la creación de imágenes. Los usuarios pueden simplemente escribir su visión, y Sora le da vida en formato de video dinámico. Aunque estos videos actualmente carecen de sonido, el rápido progreso en la generación de audio y música impulsada por IA sugiere que esta función podría integrarse pronto.

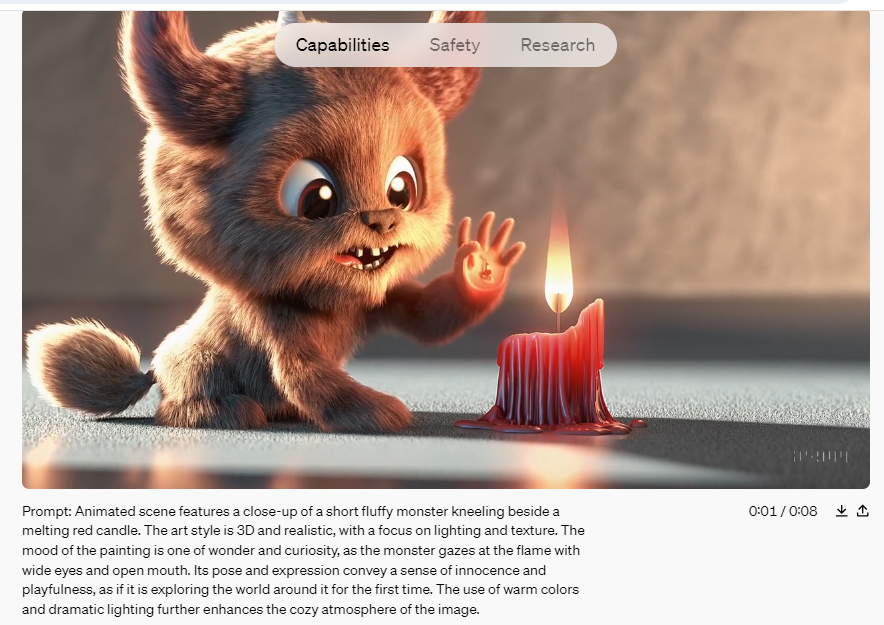

Fuente y derechos de autor: Openai.com

OpenAI presentó Sora el 16 de febrero, pero aún no se ha puesto a disposición del público en general. Actualmente, la compañía solo permite que un grupo selecto de artistas y piratas informáticos de "equipo rojo" accedan a la herramienta. Estos grupos están explorando los beneficios potenciales de la tecnología e identificando posibles usos dañinos. Sin embargo, OpenAI ha compartido numerosos videos de muestra de esta nueva herramienta en una publicación de blog que anuncia el lanzamiento, un breve informe técnico y en el perfil de X (anteriormente Twitter) del CEO y fundador Sam Altman.

¿Cómo funciona Sora?

La notable capacidad de Sora radica en su capacidad para crear videos que exhiben un alto grado de realismo. Esto incluye la representación precisa de objetos y escenarios, así como sus movimientos e interacciones dentro de una escena determinada. Entrenado con principios como la iluminación realista, las texturas naturales y la dinámica de movimiento fluida, Sora va más allá de las simples imágenes para capturar detalles sutiles que animan un video.

Al igual que los modelos de IA de texto a imagen como DALL· E 3 y Midjourney, Sora funciona como un programa informático diseñado para convertir descripciones de texto en el contenido de video correspondiente. Más precisamente, Sora utiliza un modelo de difusión combinado con una arquitectura de codificación de transformador, que es similar a la de ChatGPT. Este proceso comienza con un patrón de ruido aleatorio, que la IA refina progresivamente para que coincida más estrechamente con el mensaje de entrada.

Una descripción técnica proporcionada por OpenAI explica que, en los modelos de difusión, las imágenes se segmentan en "parches" rectangulares más pequeños que son tridimensionales, que se extienden a través del tiempo. Estos parches funcionan de manera similar a los "tokens" en modelos de lenguaje grandes, representando partes de una secuencia de imágenes en lugar de partes de texto. La arquitectura del transformador organiza estos parches, mientras que el proceso de difusión rellena el contenido detallado de cada parche.

Para gestionar las demandas computacionales de la generación de video, el modelo emplea un paso de reducción de dimensionalidad durante la creación de parches, evitando así los cálculos en cada píxel de cada fotograma.

Imagínese comenzar con un lienzo cubierto de ruido visual aleatorio, similar a la estática de un televisor viejo. Usando un mensaje de texto específico, Sora refina metódicamente este ruido en una imagen coherente y, finalmente, en una serie fluida de imágenes que componen un video.

Al igual que ChatGPT, que interpreta las palabras en función de su contexto para formular oraciones coherentes, Sora comprende la dinámica de las acciones e interacciones del mundo real. El uso efectivo de Sora depende de proporcionar indicaciones precisas y claras, de la misma manera que uno interactuaría con ChatGPT.

Explicación del entrenamiento de Sora

OpenAI desarrolló Sora entrenándolo en una amplia gama de videos de acceso público, que incluyen todo, desde videos de selfies personales hasta largometrajes, imágenes de televisión, escenas del mundo real, capturas de videojuegos y mucho más, para los que previamente había adquirido derechos de licencia. Para mejorar la comprensión de Sora del contenido del mundo real, la empresa utilizó un motor de video a texto que generaba subtítulos y etiquetas a partir de los datos de video.

Si bien OpenAI no ha revelado el número exacto de videos utilizados en el proceso de entrenamiento, se cree que involucra millones de videos. Algunos expertos sugieren que OpenAI también podría haber incorporado datos sintéticos de herramientas de desarrollo de videojuegos como Unreal Engine.

A lo largo de la fase de capacitación, se contrató a expertos en seguridad y "miembros del equipo rojo" para monitorear, etiquetar y bloquear cualquier posible uso indebido que involucrara información errónea, sesgo o contenido de odio a través de rigurosas pruebas adversarias. Los videos producidos por Sora contienen etiquetas de metadatos que los identifican como generados por IA, y existen clasificadores de texto para garantizar que las indicaciones cumplan con las políticas de uso.

Según OpenAI, Sora estará sujeto a estrictas restricciones de contenido tras su lanzamiento. Estas restricciones impedirán la generación de imágenes que representen a personas reales y prohibirán el contenido que incluya violencia extrema, temas sexuales, imágenes de odio, semejanzas de celebridades o la propiedad intelectual de otros, como logotipos y productos. Estas son limitaciones similares a las que se enfrenta DALL-E 3.

Actualmente, Sora no está disponible para el público en general. Después de la fase de prueba, se pondrá a disposición de un grupo limitado de artistas visuales, diseñadores y cineastas para evaluar cómo estos profesionales creativos pueden aprovechar la herramienta.

Se prevé que Sora acabe haciéndose público, pero dadas sus potentes capacidades, se espera que funcione con un modelo de pago por uso similar al de GPT.

¿Qué esperar de Sora?

A partir de los videos que se han publicado, es evidente que Sora es muy superior a cualquier intento anterior de generación de videos de IA. Sora ahora produce videos con iluminación precisa, reflejos y expresiones humanas realistas.

Sin embargo, Sora no es perfecto. Al observar una colección de videos generados por Sora, uno puede detectar fácilmente errores como partes del cuerpo que desaparecen y reaparecen, personajes que se materializan de la nada y pies que parecen flotar sobre el suelo. Actualmente, solo tenemos acceso a una gama selecta de videos proporcionados por OpenAI, pero una vez que el público tenga acceso, es probable que surjan videos más imperfectos, lo que destaca tanto las fortalezas como las limitaciones del modelo.

A pesar de estos problemas, no hay duda de que Sora representa un desarrollo innovador. El potencial de este modelo generativo es inmenso. En su forma más básica, Sora permite la creación de videos a partir de indicaciones de texto, aunque su utilidad en el mundo real aún está por verse. Si bien las imágenes generadas por IA no han reemplazado a los fotógrafos y otros profesionales creativos, se utilizan cada vez más, especialmente en línea. Las capacidades de Sora podrían simplificar la producción de video y la creación de efectos especiales, reduciendo la necesidad de software especializado.

Sin embargo, el poder de estas tecnologías también plantea preocupaciones sobre los deepfakes. Aunque las herramientas actuales ya facilitan su creación, los modelos de IA de texto a video como Sora podrían facilitar aún más a quienes tienen malas intenciones la producción de deepfakes realistas con poco esfuerzo. Aunque es posible que la calidad del video aún no sea completamente convincente, es solo cuestión de tiempo antes de que mejore, lo que presenta desafíos significativos para distinguir los videos generados por IA de las imágenes genuinas.

OpenAI ha puesto en marcha fuertes salvaguardas para evitar el uso indebido de sus modelos, un estándar que no aplican universalmente otras plataformas que utilizan modelos similares de código abierto. Es probable que los próximos años sean desafiantes a medida que la sociedad se adapte a la creciente facilidad y asequibilidad de la producción de videos falsos.